O mundo digital está em constante evolução, e um catalisador que diferencia esta plataforma das demais é conteúdo gerado pelo usuário. Embora as empresas em todo o mundo tenham seus sites e presença dedicada nas mídias sociais, é mais provável que os usuários confiem nas opiniões de seus colegas clientes do que nas palavras da empresa.

Mais de 4.26 bilhão de pessoas eram usuários ativos de mídia social em 2021. Um número previsto para atingir a marca de 6 bilhões até 2027. A quantidade de conteúdo gerado, capturado, compartilhado e consumido em escala global atingiu 64.2 zettabytes em 2020.

Com novos conteúdos sendo gerados e consumidos em um ritmo vertiginoso, tornou-se essencial que as marcas mantenham o controle sobre o conteúdo hospedado em suas plataformas. Plataformas online deve ser e permanecer um ambiente seguro para seus usuários.

[Leia também: Compreendendo a moderação automatizada de conteúdo]

O que é moderação de conteúdo e por quê?

O conteúdo gerado pelo usuário impulsiona as plataformas de mídia social e moderação de conteúdo refere-se à triagem deste conteúdo para postagens inapropriadas ou ofensivas. As plataformas de negócios e mídias sociais possuem um padrão específico para monitorar o conteúdo de sua hospedagem.

As diretrizes podem incluir qualquer coisa, desde violência, extremismo, discurso de ódio, nudez, violação de direitos autorais ou qualquer coisa ofensiva. O conteúdo postado será sinalizado e removido se não atender ao padrão.

A ideia por trás da moderação de conteúdo é garantir que o conteúdo esteja em sintonia com os ideais da marca e defenda os valores de decência, confiança e segurança.

A moderação de conteúdo é crucial para que as empresas mantenham os padrões de negócios, a imagem da marca, a reputação e a credibilidade. A cada segundo, a quantidade impressionante de conteúdo gerado pelo usuário postado nas plataformas torna um desafio para as marcas manterem-se ofensivas e conteúdo inapropriado, texto, vídeos e imagens. A estratégia de moderação de conteúdo ajuda as marcas a manter sua imagem, permitindo que os usuários se expressem e bloqueando conteúdo ofensivo, explícito e violento.

Quais tipos de conteúdo você pode moderar?

Os algoritmos de moderação de conteúdo geralmente lidam com três ou uma combinação desses tipos de conteúdo.

Texto

A grande quantidade de texto – de comentários a artigos completos – que precisa de moderação é bastante impressionante. As postagens de texto estão disponíveis em quase qualquer lugar na forma de comentários, artigos, postagens em fóruns, discussões em mídias sociais e outras postagens.

Os algoritmos de moderação de conteúdo de texto devem ser capazes de verificar o texto de diferentes comprimentos e estilos para conteúdo indesejado. Além disso, a moderação do texto pode ser uma tarefa difícil devido às complexidades da linguagem e das nuances culturais.

Imagens

A moderação de imagem é muito mais simples do que a moderação de texto, mas é essencial ter diretrizes ou padrões adequados.

Além disso, uma vez que diferenças culturais podem entrar em jogo ao moderar imagens, é crucial entender completamente e conectar-se com a comunidade de usuários em várias localizações geográficas.

VÍDEOS

A moderação de conteúdo de vídeo é muito difícil, pois a moderação de vídeos pode ser demorada, ao contrário de texto ou imagens. O moderador deve assistir todo o vídeo antes de considerá-lo apto ou impróprio para consumo. Mesmo que apenas alguns quadros no vídeo sejam explícitos ou perturbadores, isso forçará o moderador a remover todo o conteúdo.

Transmissão ao vivo

A transmissão ao vivo é, talvez, o conteúdo mais desafiador para moderar. É porque a moderação do vídeo e do texto que o acompanha tem que acontecer simultaneamente com o streaming.

Como funciona a moderação de conteúdo?

Para começar a moderar o conteúdo em sua plataforma, você deve primeiro estabelecer padrões ou diretrizes que determinem conteúdo impróprio. Essas diretrizes ajudam os moderadores a sinalizar conteúdo para remoção.

Defina o nível de sensibilidade ou o limite que os moderadores de conteúdo devem considerar ao revisar o conteúdo. O limite deve ser definido com base na sua marca, no tipo de negócio, nas expectativas do usuário e na localização.

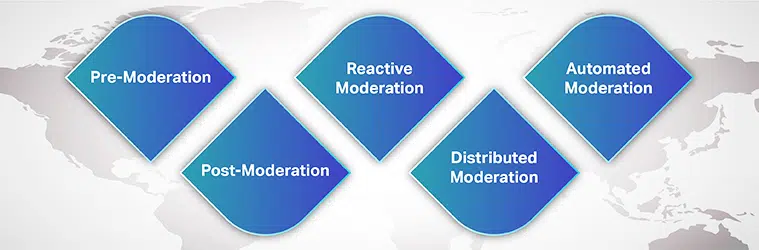

Tipos de moderação de conteúdo

Você pode escolher entre muitos processos de moderação para as necessidades da sua marca e consentimento do usuário. Alguns deles são:

Pré-Moderação

Antes de o conteúdo ser exibido em seu site, ele está na fila para moderação. Somente após o conteúdo ser analisado e considerado apto para consumo é que ele é publicado na plataforma. Embora este seja um método seguro de bloquear conteúdo explícito, é demorado.

Pós-moderação

A pós-moderação é o método padrão de moderação de conteúdo em que há uma troca entre o envolvimento do usuário e a moderação. Embora os usuários tenham permissão para postar seus envios, eles ainda estão na fila para moderação. Se o conteúdo tiver sido sinalizado, ele será revisado e removido. As empresas se esforçam para reduzir o tempo de revisão para que o conteúdo impróprio não fique online por muito tempo.

Moderação reativa

Com moderação reativa, a comunidade de usuários é incentivada a sinalizar conteúdo impróprio que viole a comunidade regras e diretrizes. Nesse método, a atenção da comunidade é atraída para o conteúdo que precisa de moderação. No entanto, o conteúdo ofensivo pode permanecer na plataforma por períodos mais longos.

Moderação distribuída

Em um método de moderação distribuída, a comunidade online pode revisar, sinalizar e remover o conteúdo que considera ofensivo e contra as diretrizes usando um sistema de classificação.

Moderação automatizada

Como o nome sugere, a moderação automatizada usa várias ferramentas e sistemas para sinalizar palavras ou frases e rejeitar envios. Ele funciona filtrando certas palavras, imagens e vídeos proibidos usando algoritmos de aprendizado de máquina.

Embora a moderação baseada em tecnologia esteja se tornando predominante, moderação humana em análise não pode ser desconsiderada. As empresas, idealmente, usam uma combinação de ferramentas automatizadas e moderadores humanos, pelo menos para situações complexas.

[Leia também: Estudo de caso – Moderação de conteúdo]

Como o Machine Learning ajuda na moderação de conteúdo?

Com mais de 5 bilhões de pessoas usando a internet e mais de 4 bilhões ativas nas redes sociais, não é fácil se surpreender com a quantidade de imagens, textos, vídeos, postagens e mensagens geradas diariamente. Esse conteúdo gigantesco deve ser moderado de alguma forma para que os usuários que acessam seus sites de mídia social possam ter uma experiência agradável e enriquecedora.

A moderação de conteúdo surgiu como a solução para remover conteúdo explícito, ofensivo, abusivo, fraudulento ou contrário ao ethos da marca. Tradicionalmente, as empresas confiam inteiramente em moderadores humanos para revisar o conteúdo online gerado pelo usuário publicado em suas plataformas. No entanto, depender inteiramente de moderadores humanos pode tornar o processo demorado, caro e ineficiente.

As empresas agora estão empregando algoritmos de aprendizado de máquina para moderar o conteúdo de forma automática e eficiente. Alimentado por AI a moderação de conteúdo tornou todo o processo eficiente, rápido, consistente e econômico.

Embora esse processo não elimine a necessidade de moderadores humanos – humano no circuito, a contribuição de moderadores humanos ajuda a lidar com questões complexas. Além disso, os moderadores humanos entendem melhor as nuances da linguagem, as diferenças culturais e o contexto. Quando ferramentas automatizadas são usadas, com a ajuda de moderadores humanos, reduz o impacto psicológico da exposição ao conteúdo desencadeador.

Desafios da moderação de conteúdo

Outro grande desafio quando se trata de desenvolver um algoritmo de moderação de conteúdo preciso é o idioma. Um aplicativo de moderação de conteúdo confiável deve ser capaz de reconhecer vários idiomas e entender nuances culturais, contextos sociais e dinamismo linguístico.

Como uma linguagem passa por várias mudanças ao longo do tempo, como certas palavras que eram inocentes ontem poderiam ganhar notoriedade hoje – o modelo de ML precisa acompanhar o mundo em mudança. Por exemplo, uma pintura nua pode ser explícita e voyeurística ou simplesmente arte.

Como um pedaço de conteúdo é percebido ou considerado inadequado depende do contexto. E é crucial ter consistência e padrões em sua plataforma para que seus usuários possam confiar em seus esforços de moderação.

Um usuário típico sempre tenta encontrar brechas em suas diretrizes e ignorar as regras de moderação. No entanto, seu algoritmo de ML deve ser capaz de evoluir continuamente com os tempos de mudança.

Por fim, é a questão do preconceito. Diversificar seu banco de dados de treinamento e modelos de treinamento para detectar o contexto é fundamental. Embora o desenvolvimento de um algoritmo de moderação de conteúdo confiável possa parecer desafiador, ele começa com a obtenção de conjuntos de dados de treinamento de alta qualidade.

Fornecedores terceirizados com conhecimento e experiência adequados no fornecimento de conjuntos de dados de treinamento adequados são os lugares certos para começar.

Todo negócio com presença social precisa de um solução de moderação de conteúdo que ajuda a construir a confiança do cliente e uma experiência impecável. Para construir o aplicativo e treinar seu modelo de aprendizado de máquina, você precisa de acesso a um banco de dados de alta qualidade sem preconceitos, alinhado com as últimas tendências de linguística e conteúdo específico do mercado.

Com nossos anos de experiência ajudando empresas a lançar modelos de IA, Saip oferece sistemas abrangentes de coleta de dados que atendem a diversas necessidades de moderação de conteúdo.