No florescente campo da inteligência artificial (IA), o foco em considerações éticas e na justiça é mais do que um imperativo moral – é uma necessidade fundamental para a longevidade da tecnologia e a aceitação social. A IA Ética, ou IA Justa, visa garantir que os sistemas de IA operem sem preconceitos, discriminação ou resultados injustos. Este blog explora a importância da IA ética e investiga os vários tipos de preconceitos a serem evitados.

Por que a IA ética é importante

Os sistemas de IA estão cada vez mais a fazer parte da nossa vida quotidiana, tomando decisões que afetam tudo, desde candidaturas a empregos a sentenças judiciais. Quando estes sistemas são tendenciosos, podem perpetuar e amplificar as desigualdades sociais, causando danos a indivíduos e grupos. A IA ética visa prevenir tais resultados, promovendo a justiça, a responsabilização, a transparência e o respeito pelos direitos humanos.

Tipos de preconceitos e exemplos

Viés de violência

Os sistemas de IA devem ser treinados para reconhecer e omitir conteúdos violentos. Por exemplo, um modelo de linguagem treinado em textos violentos pode gerar conteúdos nocivos, promovendo a agressão em vez do diálogo construtivo.

Tópicos controversos

Treinar a IA em tópicos controversos sem moderação cuidadosa pode levar a IA a adotar posturas polarizadas. Por exemplo, uma IA treinada em dados sobre direitos de armas pode gerar argumentos controversos e unilaterais.

Viés de gênero

Um exemplo clássico de preconceito de género é quando um modelo de linguagem associa enfermeiros a mulheres e engenheiros a homens, reforçando estereótipos ultrapassados em vez de reflectir a diversidade destas profissões.

Preconceito racial e étnico

Consideremos uma IA que gera imagens de CEOs, mas que os retrata predominantemente como pertencentes a um único grupo racial, ignorando assim a realidade da diversidade no mundo empresarial.

Viés socioeconômico

Os sistemas de IA podem favorecer a linguagem ou os conceitos associados a um estatuto socioeconómico mais elevado, como assumir que as marcas de luxo são o padrão de qualidade, negligenciando o espectro mais amplo de experiências de consumo.

Viés de idade

A IA pode assumir incorretamente que as referências à tecnologia não são relevantes para os idosos, excluindo-os assim das conversas sobre os avanços digitais.

Viés cultural

Um sistema de IA pode gerar avaliações de restaurantes centradas na cozinha ocidental, desconsiderando a riqueza de outras tradições culinárias e, assim, marginalizando as culturas não ocidentais.

Viés político

Uma IA programada para selecionar artigos de notícias pode selecionar desproporcionalmente artigos do extremo esquerdo ou direito do espectro político, em vez de apresentar uma visão equilibrada.

Viés religioso

Se um sistema de IA fizer referência desproporcional a uma religião de forma positiva, ignorando ou deturpando outras, ele apresenta preconceito religioso.

Viés regional

Um modelo linguístico pode gerar relatórios de tráfego relevantes apenas para áreas urbanas, com vista para regiões rurais ou menos povoadas.

Viés de deficiência

Consideremos um consultor de saúde de IA que não fornece opções de exercícios acessíveis para pessoas com deficiência, oferecendo assim conselhos incompletos e excludentes.

Viés de linguagem

Uma IA de tradução pode fornecer consistentemente traduções de alta qualidade para alguns idiomas, mas abaixo da média para idiomas menos representados em seus dados de treinamento.

Viés de confirmação

Uma IA pode amplificar a crença de um utilizador num remédio falso, referenciando seletivamente fontes que apoiam esse remédio e ignorando o consenso científico.

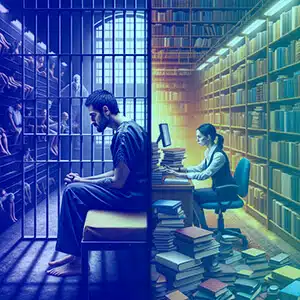

Viés contextual

Uma IA pode interpretar pedidos de informação sobre “prisões” como um inquérito criminal, em vez de um inquérito académico ou jurídico, dependendo do contexto em que foi treinado.

Viés da fonte de dados

Se os dados de treinamento de uma IA vierem de um fórum que discute predominantemente as conquistas de um determinado grupo demográfico, ela poderá negligenciar as contribuições de outros grupos.

Como evitar esses preconceitos

Evitar esses preconceitos requer uma abordagem multifacetada:

- Conjuntos de dados diversos: Incorpore uma ampla variedade de fontes de dados para equilibrar a representação entre diferentes grupos.

- Auditoria Regular: Execute verificações contínuas para identificar e corrigir preconceitos.

- Transparência: Deixe claro como os sistemas de IA tomam decisões e com base em quais dados são treinados.

- Inclusão em equipes de IA: Equipes diversas podem identificar melhor possíveis preconceitos que podem ser ignorados.

- Treinamento de Ética: Eduque os desenvolvedores de IA sobre a importância das considerações éticas.

- Feedback das partes interessadas: Envolva os usuários e as comunidades impactadas no processo de desenvolvimento de IA.

Por que Shaip

A Shaip, como líder em soluções de dados de IA, oferece serviços abrangentes projetados para enfrentar de frente os preconceitos da IA. Ao fornecer conjuntos de dados diversificados e equilibrados para treinar modelos de IA, a Shaip garante que seus sistemas de IA sejam expostos a um amplo espectro de experiências humanas e demográficas, reduzindo o risco de preconceitos em todas as frentes – desde gênero e raça até idioma e deficiência. Seus rigorosos processos de curadoria e anotação de dados, juntamente com uma estrutura ética de IA, podem ajudar as organizações a identificar, mitigar e prevenir a incorporação de preconceitos nos sistemas de IA. A experiência da Shaip no desenvolvimento de modelos personalizados também significa que eles podem ajudar na criação de uma IA que seja tão inclusiva, justa e imparcial quanto possível, alinhando-se com os padrões globais de IA Ética.

Conclusão

A IA ética é crucial para criar um futuro onde a tecnologia sirva a humanidade sem preconceitos. Ao compreender e mitigar preconceitos, os desenvolvedores e as partes interessadas podem garantir que os sistemas de IA sejam justos e equitativos. A responsabilidade cabe a todos os envolvidos no ciclo de vida da IA de promover um ambiente onde a tecnologia espelhe os nossos mais elevados padrões éticos, promovendo uma sociedade justa e inclusiva. Através da vigilância e da dedicação a estes princípios, a IA pode atingir o seu verdadeiro potencial como força para o bem.