Large Language Models (LLM): Guia Completo em 2023

Tudo o que você precisa saber sobre LLM

Tabela de índice

- Introdução

- O que são grandes modelos de linguagem?

- Fatores Essenciais

- Exemplos populares de LLM

- Blocos de construção de LLMs

- Como os modelos LLM são treinados?

- O LLM conta com aprendizado supervisionado ou não supervisionado

- Treinar LLM

- A Ascensão do LLM

- Casos de uso populares de LLM

- Segurança e Conformidade

- Ajustando um LLM

- Perguntas frequentes

Baixar eBook

Introdução

Já coçou a cabeça, surpreso com a forma como o Google ou o Alexa pareciam 'pegar' você? Ou você se pegou lendo um ensaio gerado por computador que soa estranhamente humano? Você não está sozinho. É hora de abrir a cortina e revelar o segredo: Large Language Models, ou LLMs.

O que são estes, você pergunta? Pense nos LLMs como assistentes ocultos. Eles alimentam nossos bate-papos digitais, entendem nossas frases confusas e até escrevem como nós. Eles estão transformando nossas vidas, tornando a ficção científica uma realidade.

Este guia é sobre todas as coisas LLM. Exploraremos o que eles podem fazer, o que não podem fazer e onde são usados. Examinaremos como eles impactam a todos nós em linguagem clara e simples.

Então, vamos começar nossa emocionante jornada em LLMs.

Para quem é este guia?

Este extenso guia é para:

- Todos vocês empreendedores e empreendedores individuais que estão processando uma enorme quantidade de dados regularmente

- IA e aprendizado de máquina ou profissionais que estão começando com técnicas de otimização de processos

- Gerentes de projeto que pretendem implementar um time-to-market mais rápido para seus módulos de IA ou produtos orientados por IA

- E entusiastas de tecnologia que gostam de entrar nos detalhes das camadas envolvidas nos processos de IA.

O que são grandes modelos de linguagem?

Os Large Language Models (LLMs) são sistemas avançados de inteligência artificial (IA) projetados para processar, entender e gerar texto semelhante ao humano. Eles são baseados em técnicas de aprendizado profundo e treinados em grandes conjuntos de dados, geralmente contendo bilhões de palavras de diversas fontes, como sites, livros e artigos. Este treinamento extensivo permite que os LLMs compreendam as nuances da linguagem, gramática, contexto e até mesmo alguns aspectos do conhecimento geral.

Alguns LLMs populares, como o GPT-3 da OpenAI, empregam um tipo de rede neural chamada transformador, que permite lidar com tarefas complexas de linguagem com proficiência notável. Esses modelos podem executar uma ampla gama de tarefas, como:

- Respondendo a perguntas

- Resumindo o texto

- Traduzindo idiomas

- Gerando conteúdo

- Mesmo participando de conversas interativas com os usuários

À medida que os LLMs continuam a evoluir, eles têm grande potencial para aprimorar e automatizar vários aplicativos em todos os setores, desde atendimento ao cliente e criação de conteúdo até educação e pesquisa. No entanto, eles também levantam preocupações éticas e sociais, como comportamento tendencioso ou uso indevido, que precisam ser abordados à medida que a tecnologia avança.

Fatores essenciais na construção de um corpus de dados LLM

Você deve construir um corpus de dados abrangente para treinar modelos de linguagem com sucesso. Este processo envolve a coleta de vastos dados e a garantia de sua alta qualidade e relevância. Vejamos os principais aspectos que influenciam significativamente o desenvolvimento de uma biblioteca de dados eficaz para treinamento de modelos de linguagem.

Priorize a qualidade dos dados junto com a quantidade

Um grande conjunto de dados é fundamental para treinar modelos de linguagem. No entanto, há muita importância associada à qualidade dos dados. Modelos treinados em dados extensos, mas mal estruturados, podem produzir resultados imprecisos.

Por outro lado, conjuntos de dados menores e meticulosamente selecionados geralmente levam a um desempenho superior. Esta realidade mostra a importância de uma abordagem equilibrada na recolha de dados. Dados representativos, diversos e pertinentes ao escopo pretendido do modelo requerem seleção, limpeza e organização diligentes.

Selecione fontes de dados apropriadas

A escolha das fontes de dados deve estar alinhada com os objetivos específicos da aplicação do modelo.

- Modelos que geram diálogo se beneficiariam de fontes como conversas e entrevistas que são inestimáveis.

- Os modelos focados na geração de código se beneficiarão de repositórios de código bem documentados.

- Obras literárias e roteiros oferecem uma riqueza de material de treinamento para aqueles que buscam a escrita criativa.

Você deve incluir dados que abrangem os idiomas e tópicos pretendidos. Ele ajuda você a adaptar o modelo para um desempenho eficaz dentro do domínio designado.

Use geração de dados sintéticos

Aprimorar seu conjunto de dados com dados sintéticos pode preencher lacunas e ampliar seu alcance. Você pode usar aumento de dados, modelos de geração de texto e geração baseada em regras para criar dados artificiais que reflitam padrões do mundo real. Esta estratégia amplia a diversidade do conjunto de formação para aumentar a resiliência do modelo e ajudar a reduzir preconceitos.

Certifique-se de verificar a qualidade dos dados sintéticos para que contribuam positivamente para a capacidade do modelo de compreender e gerar linguagem dentro do seu domínio de destino.

Implementar coleta automatizada de dados

A automação do processo de coleta de dados facilita a integração consistente de dados novos e relevantes. Essa abordagem simplifica a aquisição de dados, aumenta a escalabilidade e promove a reprodutibilidade.

Você pode coletar conjuntos de dados variados com eficiência usando ferramentas de web scraping, APIs e estruturas de ingestão de dados. Você pode ajustar essas ferramentas para se concentrar em dados relevantes e de alta qualidade. Eles otimizam o material de treinamento do modelo. Você deve monitorar continuamente esses sistemas automatizados para manter sua precisão e integridade ética.

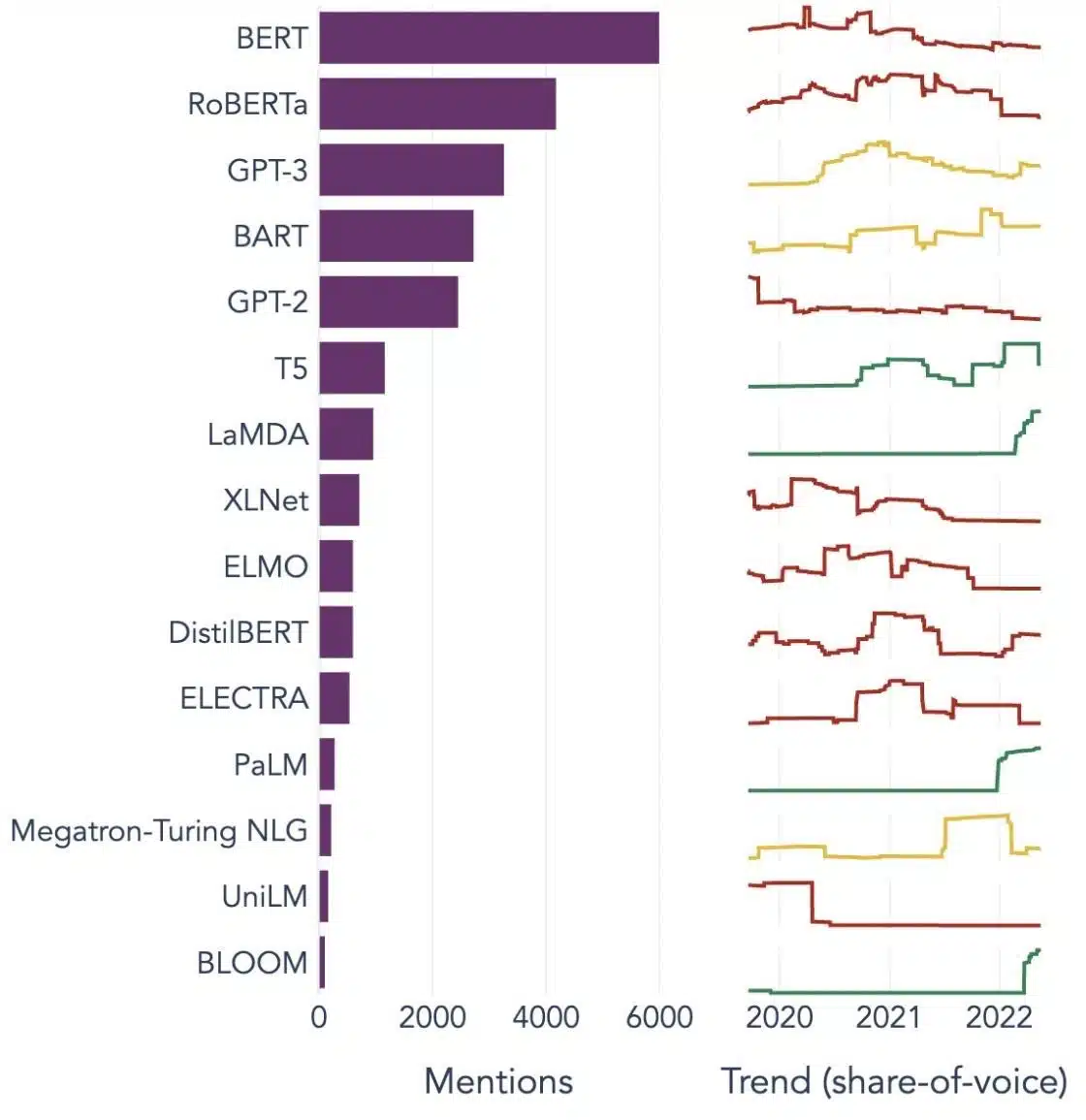

Exemplos populares de modelos de linguagem grandes

Aqui estão alguns exemplos proeminentes de LLMs amplamente utilizados em diferentes verticais da indústria:

Fonte da imagem: Em direção à ciência de dados

Compreendendo os blocos de construção de grandes modelos de linguagem (LLMs)

Para compreender totalmente os recursos e o funcionamento dos LLMs, é importante nos familiarizarmos com alguns conceitos-chave. Esses incluem:

Incorporação de palavras

Isso se refere à prática de traduzir palavras em um formato numérico que os modelos de IA possam interpretar. Em essência, a incorporação de palavras é a linguagem da IA. Cada palavra é representada como um vetor de alta dimensão que encapsula seu significado semântico com base em seu contexto nos dados de treinamento. Esses vetores permitem que a IA entenda as relações e semelhanças entre as palavras, melhorando a compreensão e o desempenho do modelo.

Mecanismos de Atenção

Esses componentes sofisticados ajudam o modelo de IA a priorizar certos elementos no texto de entrada em detrimento de outros ao gerar uma saída. Por exemplo, em uma frase preenchida com vários sentimentos, um mecanismo de atenção pode dar maior peso às palavras que carregam sentimentos. Essa estratégia permite que a IA gere respostas mais contextualmente precisas e diferenciadas.

transformadores

Os transformadores representam um tipo avançado de arquitetura de rede neural amplamente empregada na pesquisa LLM. O que diferencia os transformadores é seu mecanismo de auto-atenção. Esse mecanismo permite que o modelo pondere e considere todas as partes dos dados de entrada simultaneamente, em vez de em ordem sequencial. O resultado é uma melhoria na manipulação de dependências de longo alcance no texto, um desafio comum em tarefas de processamento de linguagem natural.

Afinação

Mesmo os LLMs mais avançados exigem alguma adaptação para se destacar em tarefas ou domínios específicos. É aqui que entra o ajuste fino. Depois que um modelo é inicialmente treinado em um grande conjunto de dados, ele pode ser refinado ou 'ajustado' em um conjunto de dados menor e mais específico. Esse processo permite que o modelo adapte suas habilidades de compreensão de linguagem generalizada a uma tarefa ou contexto mais especializado.

Engenharia imediata

Os prompts de entrada servem como ponto de partida para os LLMs gerarem saídas. Elaborar esses prompts de maneira eficaz, uma prática conhecida como engenharia de prompts, pode influenciar bastante a qualidade das respostas do modelo. É uma mistura de arte e ciência que requer uma compreensão aguçada de como o modelo interpreta solicitações e gera respostas.

Viés

Como os LLMs aprendem com os dados nos quais são treinados, qualquer viés presente nesses dados pode se infiltrar no comportamento do modelo. Isso pode se manifestar como tendências discriminatórias ou injustas nos resultados do modelo. Abordar e mitigar esses vieses é um desafio significativo no campo da IA e um aspecto crucial do desenvolvimento de LLMs eticamente sólidos.

Interpretabilidade

Dada a complexidade dos LLMs, entender por que eles tomam certas decisões ou geram resultados específicos pode ser um desafio. Essa característica, conhecida como interpretabilidade, é uma área-chave de pesquisa em andamento. O aprimoramento da interpretabilidade não apenas ajuda na solução de problemas e no refinamento do modelo, mas também reforça a confiança e a transparência nos sistemas de IA.

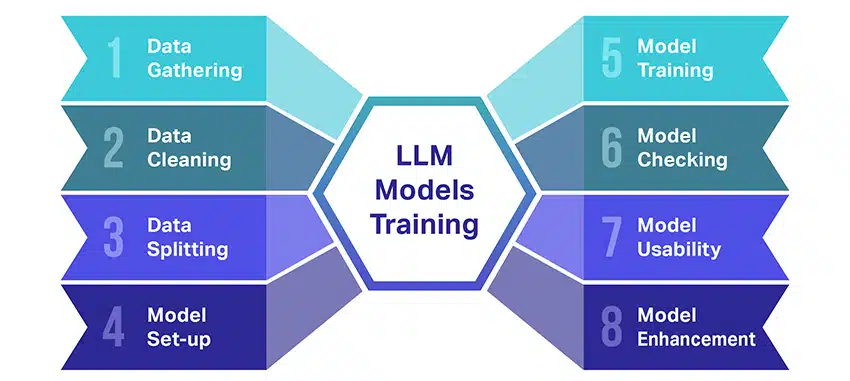

Como os modelos LLM são treinados?

O treinamento de modelos de linguagem grandes (LLMs) é uma façanha que envolve várias etapas cruciais. Aqui está um resumo passo a passo simplificado do processo:

- Coletando dados de texto: O treinamento de um LLM começa com a coleta de uma grande quantidade de dados de texto. Esses dados podem vir de livros, sites, artigos ou plataformas de mídia social. O objetivo é capturar a rica diversidade da linguagem humana.

- Limpando os dados: Os dados de texto bruto são então organizados em um processo chamado pré-processamento. Isso inclui tarefas como remover caracteres indesejados, dividir o texto em partes menores chamadas tokens e colocar tudo em um formato com o qual o modelo possa trabalhar.

- Dividindo os dados: Em seguida, os dados limpos são divididos em dois conjuntos. Um conjunto, os dados de treinamento, será usado para treinar o modelo. O outro conjunto, os dados de validação, serão usados posteriormente para testar o desempenho do modelo.

- Configurando o modelo: A estrutura do LLM, conhecida como arquitetura, é então definida. Isso envolve selecionar o tipo de rede neural e decidir sobre vários parâmetros, como o número de camadas e unidades ocultas na rede.

- Treinando o Modelo: O treinamento real agora começa. O modelo LLM aprende observando os dados de treinamento, fazendo previsões com base no que aprendeu até agora e ajustando seus parâmetros internos para reduzir a diferença entre suas previsões e os dados reais.

- Verificando o modelo: O aprendizado do modelo LLM é verificado usando os dados de validação. Isso ajuda a ver o desempenho do modelo e a ajustar as configurações do modelo para um melhor desempenho.

- Usando o modelo: Após treinamento e avaliação, o modelo LLM está pronto para uso. Agora ele pode ser integrado a aplicativos ou sistemas onde gerará texto com base nas novas entradas fornecidas.

- Melhorando o modelo: Finalmente, sempre há espaço para melhorias. O modelo LLM pode ser refinado ao longo do tempo, usando dados atualizados ou ajustando as configurações com base no feedback e no uso do mundo real.

Lembre-se, esse processo requer recursos computacionais significativos, como unidades de processamento poderosas e grande capacidade de armazenamento, além de conhecimento especializado em aprendizado de máquina. É por isso que geralmente é feito por organizações ou empresas de pesquisa dedicadas com acesso à infraestrutura e experiência necessárias.

O LLM depende de aprendizado supervisionado ou não supervisionado?

Grandes modelos de linguagem geralmente são treinados usando um método chamado aprendizado supervisionado. Em termos simples, isso significa que eles aprendem com exemplos que mostram as respostas corretas.

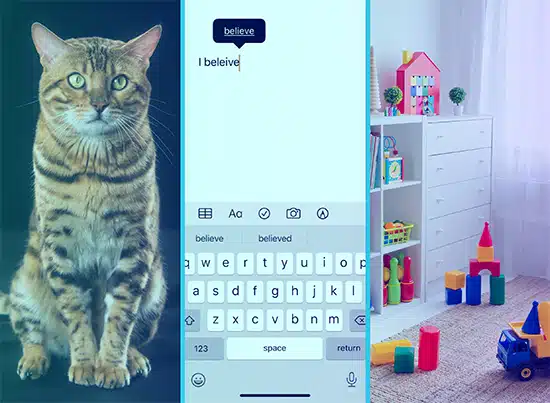

Portanto, se você alimentar um LLM com uma frase, ele tentará prever a próxima palavra ou frase com base no que aprendeu com os exemplos. Assim, ele aprende a gerar um texto que faça sentido e se encaixe no contexto.

Dito isso, às vezes os LLMs também usam um pouco de aprendizado não supervisionado. É como deixar a criança explorar uma sala cheia de brinquedos diferentes e aprender sobre eles por conta própria. O modelo analisa dados não rotulados, padrões de aprendizado e estruturas sem receber as respostas “certas”.

O aprendizado supervisionado emprega dados rotulados com entradas e saídas, em contraste com o aprendizado não supervisionado, que não usa dados de saída rotulados.

Em poucas palavras, os LLMs são treinados principalmente usando aprendizado supervisionado, mas também podem usar aprendizado não supervisionado para aprimorar suas capacidades, como para análise exploratória e redução de dimensionalidade.

Qual é o volume de dados (em GB) necessário para treinar um grande modelo de linguagem?

O mundo de possibilidades para reconhecimento de dados de fala e aplicativos de voz é imenso, e eles estão sendo usados em diversos setores para uma infinidade de aplicações.

O treinamento de um grande modelo de linguagem não é um processo único para todos, especialmente quando se trata dos dados necessários. Depende de um monte de coisas:

- O desenho do modelo.

- Que trabalho precisa fazer?

- O tipo de dados que você está usando.

- Quão bem você quer que ele funcione?

Dito isso, o treinamento de LLMs geralmente requer uma grande quantidade de dados de texto. Mas de que massa estamos falando? Bem, pense muito além dos gigabytes (GB). Normalmente, estamos analisando terabytes (TB) ou até mesmo petabytes (PB) de dados.

Considere o GPT-3, um dos maiores LLMs do mercado. É treinado em 570 GB de dados de texto. LLMs menores podem precisar de menos – talvez 10-20 GB ou até 1 GB de gigabytes – mas ainda é muito.

Mas não se trata apenas do tamanho dos dados. A qualidade também importa. Os dados precisam ser limpos e variados para ajudar o modelo a aprender de forma eficaz. E você não pode esquecer outras peças-chave do quebra-cabeça, como o poder de computação de que precisa, os algoritmos que usa para treinamento e a configuração de hardware que possui. Todos esses fatores desempenham um papel importante no treinamento de um LLM.

A ascensão de grandes modelos de linguagem: por que eles são importantes

Os LLMs não são mais apenas um conceito ou um experimento. Eles estão cada vez mais desempenhando um papel crítico em nosso cenário digital. Mas por que isso está acontecendo? O que torna esses LLMs tão importantes? Vamos nos aprofundar em alguns fatores-chave.

Domínio em imitar texto humano

Os LLMs transformaram a maneira como lidamos com tarefas baseadas em linguagem. Construídos com algoritmos robustos de aprendizado de máquina, esses modelos são equipados com a capacidade de entender as nuances da linguagem humana, incluindo contexto, emoção e até sarcasmo, até certo ponto. Esta capacidade de imitar a linguagem humana não é uma mera novidade, tem implicações significativas.

As habilidades avançadas de geração de texto dos LLMs podem aprimorar tudo, desde a criação de conteúdo até as interações de atendimento ao cliente.

Imagine ser capaz de fazer uma pergunta complexa a um assistente digital e obter uma resposta que não apenas faça sentido, mas também seja coerente, relevante e entregue em tom de conversa. É isso que os LLMs estão permitindo. Eles estão alimentando uma interação homem-máquina mais intuitiva e envolvente, enriquecendo as experiências do usuário e democratizando o acesso à informação.

Poder de computação acessível

A ascensão dos LLMs não teria sido possível sem desenvolvimentos paralelos no campo da computação. Mais especificamente, a democratização dos recursos computacionais desempenhou um papel significativo na evolução e adoção dos LLMs.

As plataformas baseadas em nuvem estão oferecendo acesso sem precedentes a recursos de computação de alto desempenho. Dessa forma, até mesmo organizações de pequena escala e pesquisadores independentes podem treinar modelos sofisticados de aprendizado de máquina.

Além disso, as melhorias nas unidades de processamento (como GPUs e TPUs), combinadas com o surgimento da computação distribuída, tornaram viável o treinamento de modelos com bilhões de parâmetros. Essa maior acessibilidade do poder de computação está permitindo o crescimento e o sucesso dos LLMs, levando a mais inovações e aplicações no campo.

Mudança nas preferências do consumidor

Os consumidores de hoje não querem apenas respostas; eles querem interações envolventes e relacionáveis. À medida que mais pessoas crescem usando a tecnologia digital, fica evidente que aumenta a necessidade de uma tecnologia que pareça mais natural e humana. Os LLMs oferecem uma oportunidade inigualável de atender a essas expectativas. Ao gerar texto semelhante ao humano, esses modelos podem criar experiências digitais envolventes e dinâmicas, que podem aumentar a satisfação e a fidelidade do usuário. Sejam chatbots de IA fornecendo atendimento ao cliente ou assistentes de voz fornecendo atualizações de notícias, os LLMs estão inaugurando uma era de IA que nos entende melhor.

A mina de ouro dos dados não estruturados

Dados não estruturados, como e-mails, postagens em mídias sociais e avaliações de clientes, são um tesouro de insights. Estima-se que mais de 80% dos dados corporativos é desestruturado e cresce a uma taxa de 55% por ano. Esses dados são uma mina de ouro para as empresas, se aproveitados adequadamente.

Os LLMs entram em jogo aqui, com sua capacidade de processar e dar sentido a esses dados em escala. Eles podem lidar com tarefas como análise de sentimento, classificação de texto, extração de informações e muito mais, fornecendo informações valiosas.

Seja identificando tendências de postagens de mídia social ou avaliando o sentimento do cliente a partir de avaliações, os LLMs estão ajudando as empresas a navegar na grande quantidade de dados não estruturados e a tomar decisões baseadas em dados.

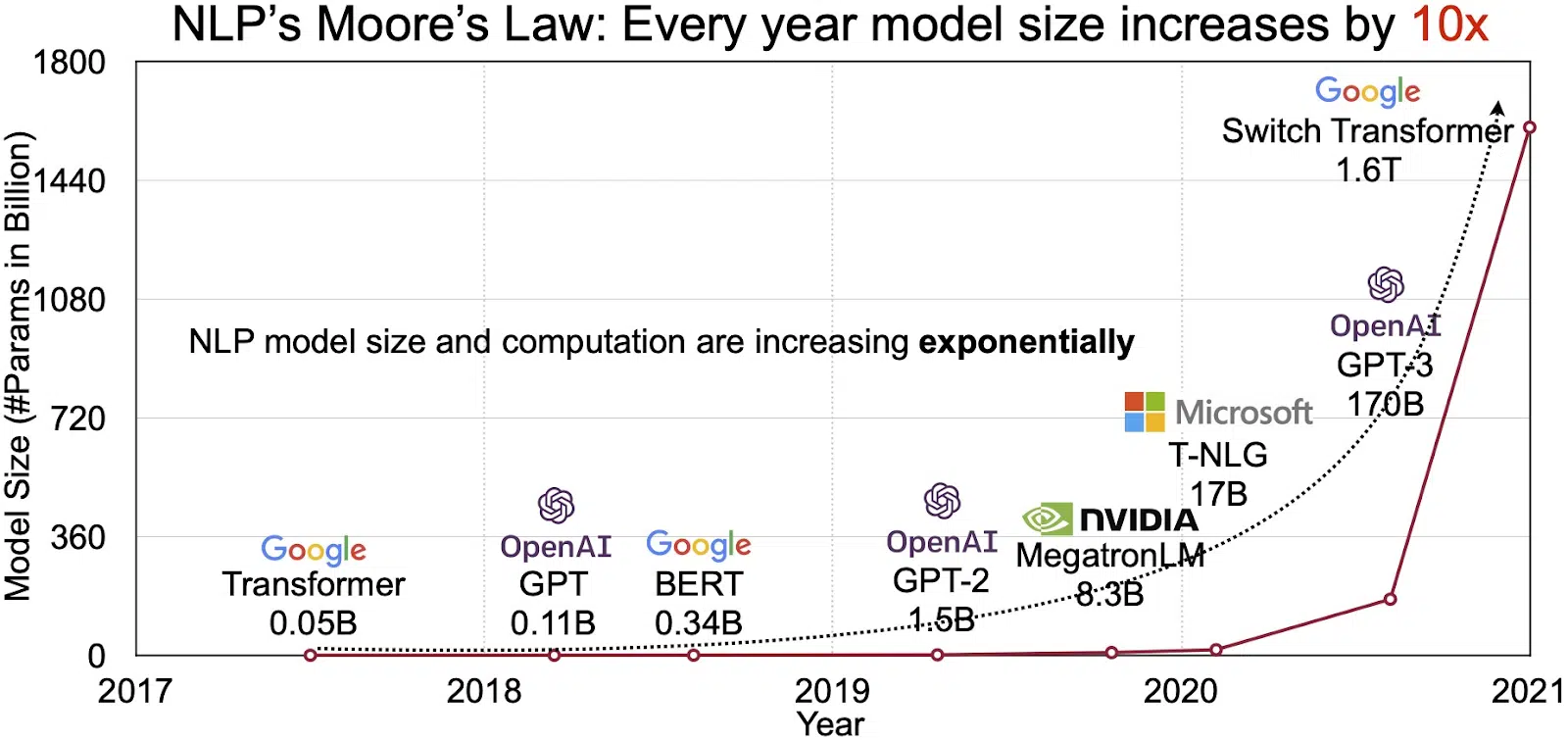

O mercado de PNL em expansão

O potencial dos LLMs se reflete no mercado de rápido crescimento para processamento de linguagem natural (NLP). Analistas projetam expansão do mercado de NLP de US$ 11 bilhões em 2020 para mais de US$ 35 bilhões em 2026. Mas não é apenas o tamanho do mercado que está se expandindo. Os próprios modelos também estão crescendo, tanto em tamanho físico quanto no número de parâmetros que manipulam. A evolução dos LLMs ao longo dos anos, como pode ser visto na figura abaixo (fonte da imagem: link), ressalta sua crescente complexidade e capacidade.

Casos de uso populares de grandes modelos de linguagem

Aqui estão alguns dos principais e mais comuns casos de uso do LLM:

- Gerando texto em linguagem natural: Os Large Language Models (LLMs) combinam o poder da inteligência artificial e da linguística computacional para produzir autonomamente textos em linguagem natural. Eles podem atender a diversas necessidades do usuário, como escrever artigos, criar músicas ou se envolver em conversas com os usuários.

- Tradução através de máquinas: Os LLMs podem ser efetivamente empregados para traduzir texto entre qualquer par de idiomas. Esses modelos exploram algoritmos de aprendizado profundo, como redes neurais recorrentes, para compreender a estrutura linguística dos idiomas de origem e de destino, facilitando assim a tradução do texto de origem para o idioma desejado.

- Criação de conteúdo original: Os LLMs abriram caminhos para as máquinas gerarem conteúdo coeso e lógico. Esse conteúdo pode ser usado para criar postagens de blog, artigos e outros tipos de conteúdo. Os modelos exploram sua profunda experiência de aprendizado profundo para formatar e estruturar o conteúdo de uma maneira nova e amigável.

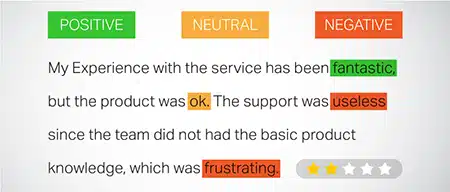

- Análise de Sentimentos: Uma aplicação intrigante dos Large Language Models é a análise de sentimento. Nele, o modelo é treinado para reconhecer e categorizar estados emocionais e sentimentos presentes no texto anotado. O software pode identificar emoções como positividade, negatividade, neutralidade e outros sentimentos complexos. Isso pode fornecer informações valiosas sobre o feedback do cliente e opiniões sobre vários produtos e serviços.

- Compreendendo, Resumindo e Classificando o Texto: Os LLMs estabelecem uma estrutura viável para o software de IA interpretar o texto e seu contexto. Ao instruir o modelo a entender e examinar grandes quantidades de dados, os LLMs permitem que os modelos de IA compreendam, resumam e até mesmo categorizem o texto em diversas formas e padrões.

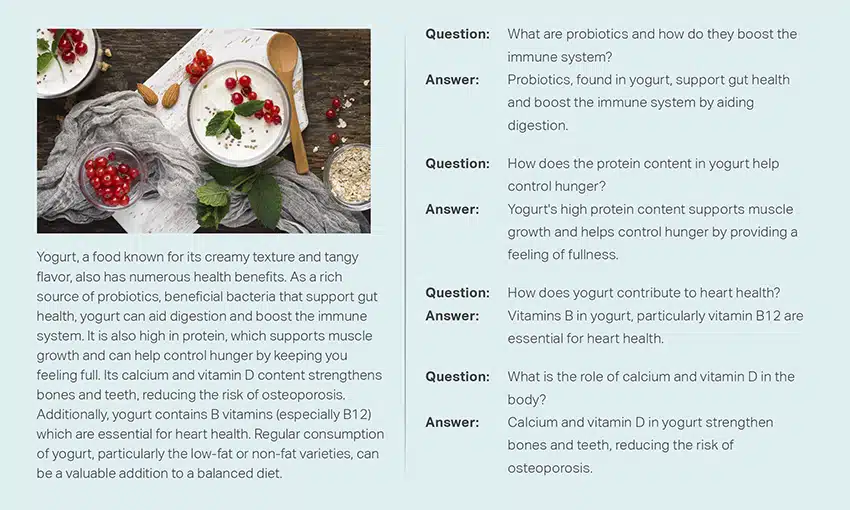

- Respondendo a perguntas: Os Large Language Models equipam os sistemas de resposta a perguntas (QA) com a capacidade de perceber e responder com precisão à consulta de linguagem natural de um usuário. Exemplos populares desse caso de uso incluem ChatGPT e BERT, que examinam o contexto de uma consulta e analisam uma vasta coleção de textos para fornecer respostas relevantes às perguntas do usuário.

Integrando segurança e conformidade em estratégias de dados LLM

Incorporar medidas robustas de segurança e conformidade nas estruturas de coleta e processamento de dados LLM pode ajudá-lo a garantir o uso transparente, seguro e ético dos dados. Esta abordagem abrange várias ações principais:

- Implementar criptografia robusta: proteja os dados em repouso e em trânsito usando métodos de criptografia fortes. Esta etapa protege as informações contra acesso não autorizado e violações.

- Estabeleça controles de acesso e autenticação: configure sistemas para verificar as identidades dos usuários e restringir o acesso aos dados. Isso garantirá que apenas pessoal autorizado possa interagir com informações confidenciais.

- Integre sistemas de registro e monitoramento: Implante sistemas para rastrear o uso de dados e identificar possíveis ameaças à segurança. Este monitoramento proativo ajuda a manter a integridade e a segurança do ecossistema de dados.

- Aderir aos padrões de conformidade: siga os regulamentos relevantes, como GDPR, HIPAA e PCI DSS, que regem a segurança e a privacidade dos dados. Auditorias e verificações regulares verificam a conformidade, garantindo que as práticas atendam aos padrões legais e éticos específicos do setor.

- Definir diretrizes de uso de dados éticos: Desenvolver e aplicar políticas que ditem o uso justo, transparente e responsável dos dados. Estas diretrizes ajudam a manter a confiança das partes interessadas e a apoiar um ambiente de formação seguro para LLMs.

Estas ações fortalecem coletivamente as práticas de gestão de dados para a formação LLM. Ele constrói uma base de confiança e segurança que beneficia todas as partes interessadas envolvidas.

Ajustando um modelo de linguagem grande

O ajuste fino de um grande modelo de linguagem envolve um processo de anotação meticuloso. Shaip, com sua experiência neste campo, pode ajudar significativamente neste empreendimento. Aqui estão alguns métodos de anotação usados para treinar modelos como o ChatGPT:

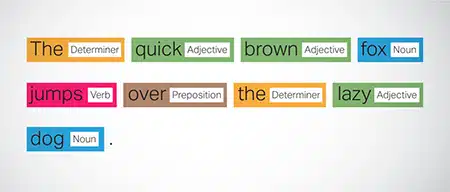

Marcação de parte do discurso (POS)

As palavras nas frases são marcadas com sua função gramatical, como verbos, substantivos, adjetivos etc. Esse processo ajuda o modelo a compreender a gramática e as ligações entre as palavras.

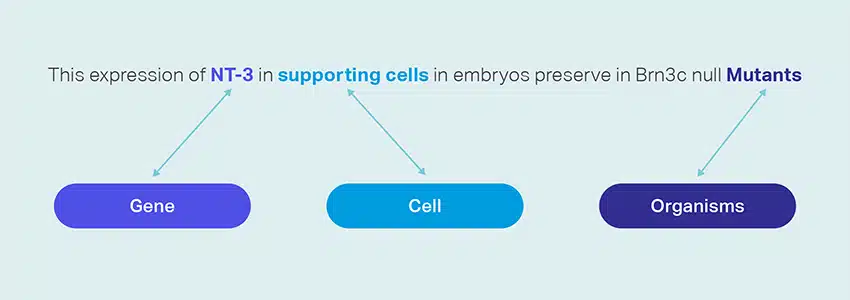

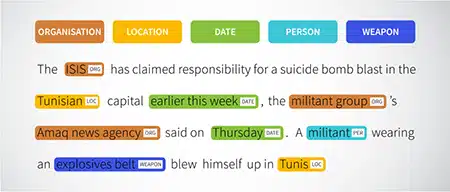

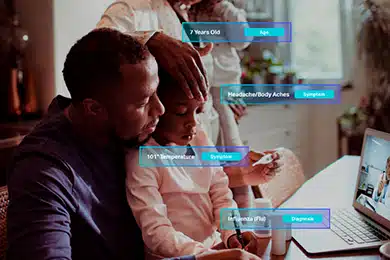

Reconhecimento de entidade nomeada (NER)

Entidades nomeadas como organizações, locais e pessoas dentro de uma frase são marcadas. Este exercício ajuda o modelo a interpretar os significados semânticos de palavras e frases e fornece respostas mais precisas.

Análise de Sentimentos

Os dados de texto recebem rótulos de sentimento como positivo, neutro ou negativo, ajudando o modelo a compreender o tom emocional das frases. É particularmente útil para responder a perguntas envolvendo emoções e opiniões.

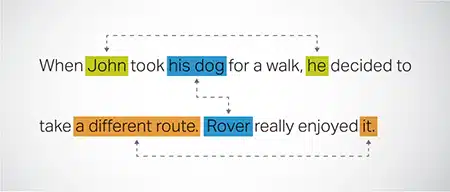

Resolução de Correferência

Identificar e resolver casos em que a mesma entidade é referida em diferentes partes de um texto. Essa etapa ajuda o modelo a entender o contexto da frase, levando a respostas coerentes.

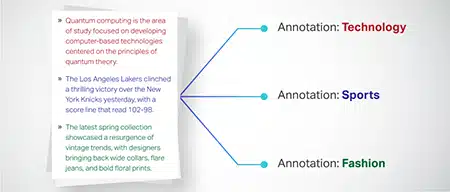

Classificação de Texto

Os dados de texto são categorizados em grupos predefinidos, como análises de produtos ou artigos de notícias. Isso auxilia o modelo a discernir o gênero ou tema do texto, gerando respostas mais pertinentes.

Saip pode coletar dados de treinamento por meio de rastreamento da Web de vários setores, como bancos, seguros, varejo e telecomunicações. Podemos fornecer anotação de texto (NER, análise de sentimento, etc.), facilitar LLM multilíngue (tradução) e auxiliar na criação de taxonomia, extração/engenharia de prompt.

Shaip tem um extenso repositório de conjuntos de dados prontos para uso. Nosso catálogo de dados médicos possui uma ampla coleção de dados não identificados, seguros e de qualidade adequados para iniciativas de IA, modelos de aprendizado de máquina e processamento de linguagem natural.

Da mesma forma, nosso catálogo de dados de fala é um tesouro de dados de alta qualidade perfeito para produtos de reconhecimento de voz, permitindo o treinamento eficiente de modelos AI/ML. Também temos um impressionante catálogo de dados de visão computacional com uma ampla gama de dados de imagem e vídeo para várias aplicações.

Oferecemos até conjuntos de dados abertos de forma modificável e conveniente, gratuitamente, para uso em seus projetos de IA e ML. Essa vasta biblioteca de dados de IA permite que você desenvolva seus modelos de IA e ML com mais eficiência e precisão.

Coleta de Dados Shaip e Processo de Anotação

Quando se trata de coleta e anotação de dados, Saip segue um fluxo de trabalho simplificado. Veja como é o processo de coleta de dados:

Identificação de sites de origem

Inicialmente, os sites são identificados usando fontes selecionadas e palavras-chave relevantes para os dados necessários.

Raspagem da web

Depois que os sites relevantes são identificados, Shaip utiliza sua ferramenta proprietária para extrair dados desses sites.

Pré-processamento de texto

Os dados coletados passam por um processamento inicial, que inclui divisão e análise de sentenças, tornando-os adequados para etapas posteriores.

Anotação

Os dados pré-processados são anotados para extração de entidade nomeada. Este processo envolve identificar e rotular elementos importantes dentro do texto, como nomes de pessoas, organizações, locais, etc.

Extração de Relacionamento

Na etapa final, os tipos de relacionamento entre as entidades identificadas são determinados e anotados de acordo. Isso ajuda a entender as conexões semânticas entre os diferentes componentes do texto.

Oferta de Shaip

Saip oferece uma ampla gama de serviços para ajudar as organizações a gerenciar, analisar e aproveitar ao máximo seus dados.

Raspagem de Dados na Web

Um serviço importante oferecido pela Shaip é a raspagem de dados. Isso envolve a extração de dados de URLs específicos do domínio. Ao utilizar ferramentas e técnicas automatizadas, a Shaip pode extrair de forma rápida e eficiente grandes volumes de dados de vários sites, manuais de produtos, documentação técnica, fóruns on-line, análises on-line, dados de atendimento ao cliente, documentos regulamentares do setor, etc. coleta de dados relevantes e específicos de uma infinidade de fontes.

Maquina de tradução

Desenvolva modelos usando extensos conjuntos de dados multilíngues emparelhados com transcrições correspondentes para traduzir texto em vários idiomas. Este processo ajuda a desmantelar os obstáculos linguísticos e promove a acessibilidade da informação.

Extração e Criação de Taxonomia

Shaip pode ajudar na extração e criação de taxonomia. Isso envolve a classificação e categorização de dados em um formato estruturado que reflete as relações entre diferentes pontos de dados. Isso pode ser particularmente útil para empresas na organização de seus dados, tornando-os mais acessíveis e fáceis de analisar. Por exemplo, em uma empresa de comércio eletrônico, os dados do produto podem ser categorizados com base no tipo de produto, marca, preço etc., facilitando a navegação dos clientes no catálogo de produtos.

Recolha de Dados

Nossos serviços de coleta de dados fornecem dados sintéticos ou do mundo real necessários para treinar algoritmos de IA generativos e melhorar a precisão e eficácia de seus modelos. Os dados são imparciais, obtidos de forma ética e responsável, mantendo em mente a privacidade e a segurança dos dados.

Perguntas e Respostas

A resposta a perguntas (QA) é um subcampo do processamento de linguagem natural focado em responder automaticamente a perguntas em linguagem humana. Os sistemas de controle de qualidade são treinados em texto e código extensos, permitindo-lhes lidar com vários tipos de questões, incluindo questões factuais, de definição e baseadas em opinião. O conhecimento do domínio é crucial para o desenvolvimento de modelos de controle de qualidade adaptados a campos específicos, como suporte ao cliente, assistência médica ou cadeia de suprimentos. No entanto, as abordagens generativas de QA permitem que os modelos gerem texto sem conhecimento de domínio, contando apenas com o contexto.

Nossa equipe de especialistas pode estudar minuciosamente documentos ou manuais abrangentes para gerar pares Pergunta-Resposta, facilitando a criação de IA Gerativa para empresas. Essa abordagem pode lidar efetivamente com as consultas do usuário, extraindo informações pertinentes de um corpus extenso. Nossos especialistas certificados garantem a produção de pares de perguntas e respostas de alta qualidade que abrangem diversos tópicos e domínios.

Resumo de Texto

Nossos especialistas são capazes de destilar conversas abrangentes ou diálogos longos, fornecendo resumos sucintos e perspicazes de extensos dados de texto.

Geração de Texto

Treine modelos usando um amplo conjunto de dados de texto em diversos estilos, como artigos de notícias, ficção e poesia. Esses modelos podem gerar vários tipos de conteúdo, incluindo notícias, entradas de blog ou postagens de mídia social, oferecendo uma solução econômica e que economiza tempo para a criação de conteúdo.

Reconhecimento de Voz

Desenvolver modelos capazes de compreender a linguagem falada para diversas aplicações. Isso inclui assistentes ativados por voz, software de ditado e ferramentas de tradução em tempo real. O processo envolve a utilização de um conjunto de dados abrangente composto por gravações de áudio da linguagem falada, emparelhadas com suas transcrições correspondentes.

Recomendações de produtos

Desenvolva modelos usando extensos conjuntos de dados de históricos de compras de clientes, incluindo rótulos que indicam os produtos que os clientes estão inclinados a comprar. O objetivo é fornecer sugestões precisas aos clientes, aumentando assim as vendas e aumentando a satisfação do cliente.

Legenda de imagem

Revolucione seu processo de interpretação de imagens com nosso serviço de legendas de imagens de última geração, orientado por IA. Infundimos vitalidade em imagens, produzindo descrições precisas e contextualmente significativas. Isso abre caminho para possibilidades inovadoras de engajamento e interação com seu conteúdo visual para seu público.

Serviços de conversão de texto em fala de treinamento

Fornecemos um extenso conjunto de dados composto por gravações de áudio de fala humana, ideal para treinar modelos de IA. Esses modelos são capazes de gerar vozes naturais e envolventes para seus aplicativos, proporcionando assim uma experiência sonora diferenciada e imersiva para seus usuários.

Nosso catálogo de dados diversificado é projetado para atender a vários casos de uso de IA generativa

Catálogo e licenciamento de dados médicos prontos para uso:

- 5M + Registros e arquivos de áudio médico em 31 especialidades

- 2M + Imagens médicas em radiologia e outras especialidades (MRIs, CTs, USGs, XRs)

- Mais de 30 mil documentos de texto clínico com entidades de valor agregado e anotação de relacionamento

Catálogo e licenciamento de dados de fala prontos para uso:

- Mais de 40 mil horas de dados de fala (mais de 50 idiomas/mais de 100 dialetos)

- Mais de 55 tópicos cobertos

- Taxa de amostragem - 8/16/44/48 kHz

- Tipo de áudio - Espontâneo, roteirizado, monólogo, palavras de despertar

- Conjuntos de dados de áudio totalmente transcritos em vários idiomas para conversas humano-humano, humano-bot, conversa de call center humano-agente, monólogos, discursos, podcasts, etc.

Catálogo de dados de imagem e vídeo e licenciamento:

- Coleção de imagens de alimentos/documentos

- Coleção de vídeos de segurança doméstica

- Coleção de imagens/vídeos faciais

- Faturas, PO, Coleta de Documentos de Recibos para OCR

- Coleta de imagens para detecção de danos em veículos

- Coleção de imagens de placas de veículos

- Coleção de imagens do interior do carro

- Coleção de imagens com motorista em foco

- Coleção de imagens relacionadas à moda

Fale connosco

Perguntas Mais Frequentes (FAQ)

DL é um subcampo de ML que utiliza redes neurais artificiais com várias camadas para aprender padrões complexos em dados. ML é um subconjunto da IA que se concentra em algoritmos e modelos que permitem que as máquinas aprendam com os dados. Os modelos de linguagem grandes (LLMs) são um subconjunto de aprendizado profundo e compartilham um terreno comum com a IA generativa, pois ambos são componentes do campo mais amplo de aprendizado profundo.

Modelos de linguagem grandes, ou LLMs, são modelos de linguagem expansivos e versáteis que são inicialmente pré-treinados em dados de texto extensos para compreender os aspectos fundamentais da linguagem. Eles são então ajustados para aplicações ou tarefas específicas, permitindo que sejam adaptados e otimizados para fins específicos.

Em primeiro lugar, grandes modelos de linguagem possuem a capacidade de lidar com uma ampla gama de tarefas devido ao seu treinamento extensivo com grandes quantidades de dados e bilhões de parâmetros.

Em segundo lugar, esses modelos exibem adaptabilidade, pois podem ser ajustados com o mínimo de dados específicos de treinamento de campo.

Por fim, o desempenho dos LLMs mostra melhoria contínua quando dados e parâmetros adicionais são incorporados, aumentando sua eficácia ao longo do tempo.

O design do prompt envolve a criação de um prompt personalizado para a tarefa específica, como especificar o idioma de saída desejado em uma tarefa de tradução. A engenharia de prompt, por outro lado, concentra-se em otimizar o desempenho incorporando conhecimento de domínio, fornecendo exemplos de saída ou usando palavras-chave eficazes. O design imediato é um conceito geral, enquanto a engenharia imediata é uma abordagem especializada. Embora o projeto imediato seja essencial para todos os sistemas, a engenharia imediata torna-se crucial para sistemas que exigem alta precisão ou desempenho.

Existem três tipos de modelos de linguagem grandes. Cada tipo requer uma abordagem diferente para promover.

- Os modelos de linguagem genéricos prevêem a próxima palavra com base na linguagem nos dados de treinamento.

- Os modelos ajustados por instrução são treinados para prever a resposta às instruções dadas na entrada.

- Os modelos ajustados para diálogo são treinados para ter uma conversa semelhante a um diálogo, gerando a próxima resposta.